OpenAI ha presentato ufficialmente tre nuovi modelli: GPT-4.1, GPT-4.1 mini e GPT-4.1 nano. Questi modelli sono dotati di enormi capacità di elaborazione del contesto, fino a 1 milione di token, e limiti di conoscenza aggiornati fino a giugno 2024.

L'azienda afferma che questi modelli superano in prestazioni i modelli GPT-4o e GPT-4o mini recentemente aggiornati, lanciati lo scorso luglio. Al momento GPT-4.1 è disponibile solo tramite API, quindi non sarà ancora possibile utilizzarlo direttamente in ChatGPT.

OpenAI sottolinea che GPT-4.1 sarà disponibile solo tramite API. In ChatGPT, molti miglioramenti nella conformità delle istruzioni, nella programmazione e nell'intelligenza sono stati gradualmente integrati nell'ultima versione di GPT-4o e l'azienda continuerà ad aggiungerne altri nelle versioni future.

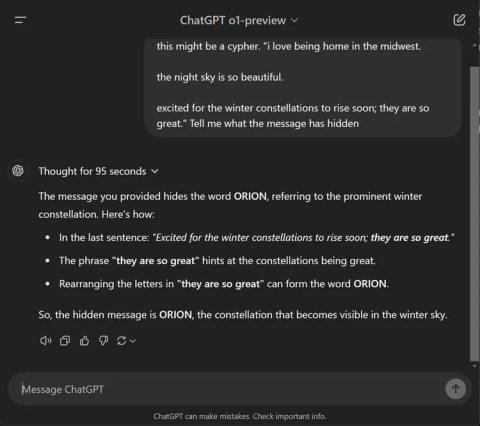

I benchmark mostrano i notevoli miglioramenti apportati da GPT-4.1. Questo modello ha ottenuto un punteggio del 54,6% su SWE-bench Verified, con un incremento di 21,4 punti rispetto a GPT-4o. Il modello ha ottenuto un punteggio del 38,3% su MultiChallenge, un benchmark che misura l'aderenza alle linee guida, e ha stabilito un nuovo record per la comprensione di video di lunga durata con un punteggio del 72,0% sul benchmark Video-MME, in cui i modelli analizzano video lunghi fino a un'ora senza sottotitoli.

OpenAI ha inoltre collaborato con partner alpha per testare le prestazioni di GPT-4.1 in casi di utilizzo reali.

- Thomson Reuters ha testato GPT-4.1 con il suo assistente legale basato sull'intelligenza artificiale CoCounsel. Rispetto a GPT-4o, GPT-4.1 registra un aumento del 17% nella precisione nella valutazione multi-documento. Questo tipo di lavoro si basa in larga misura sulla capacità di tracciare il contesto attraverso più fonti e di identificare relazioni complesse, come termini in conflitto o dipendenze nascoste, e GPT-4.1 ha costantemente dimostrato ottime prestazioni.

- Carlyle ha utilizzato GPT-4.1 per estrarre dati finanziari da documenti lunghi e complessi, tra cui file Excel e PDF. Secondo i benchmark interni dell'azienda, il modello offre prestazioni migliori del 50% rispetto ai modelli precedenti nel recupero dei documenti. È il primo modello in grado di gestire in modo affidabile problemi quali la ricerca di un "ago in un pagliaio", la perdita di informazioni nel mezzo di un documento e argomenti che richiedono il collegamento di informazioni su più file.

Le prestazioni sono una cosa, ma la velocità è altrettanto importante. OpenAI afferma che GPT-4.1 restituisce il primo token in circa 15 secondi quando elabora 128.000 token e fino a 30 secondi quando elabora un milione di token. GPT-4.1 mini e nano sono ancora più veloci.

In genere, GPT-4.1 nano risponde in meno di 5 secondi alle richieste con 128.000 token di input. La memorizzazione nella cache rapida può ridurre ulteriormente la latenza, risparmiando al contempo sui costi.

Anche la comprensione delle immagini ha fatto notevoli progressi. In particolare, GPT-4.1 mini supera GPT-4o in vari benchmark visivi.

- Su MMMU (inclusi grafici, diagrammi e mappe), GPT-4.1 mini ha ottenuto un punteggio del 73%. Questo valore è superiore a quello di GPT-4.5 e supera di gran lunga il 56% di GPT-4o mini.

- Su MathVista (che testa la capacità di risolvere problemi di immagini), sia GPT-4.1 che GPT-4.1 mini hanno ottenuto un punteggio del 57%, superando di gran lunga il 37% di GPT-4o mini.

- Su CharXiv-Reasoning , dove i modelli rispondono a domande basate su grafici scientifici, GPT-4.1 continua a essere leader.

- Su Video-MME (video lunghi senza sottotitoli), GPT-4.1 ha raggiunto il 72%, un miglioramento significativo rispetto al 65% di GPT-4o.

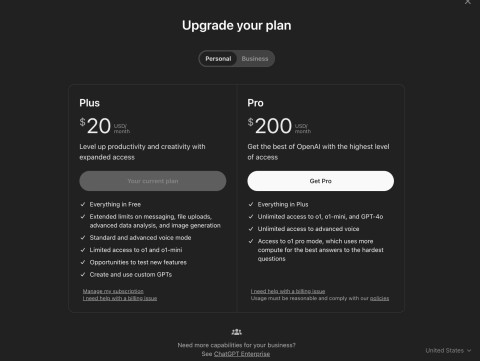

Informazioni sul prezzo:

- GPT-4.1 costa 2 $ per ogni milione di token in input e 8 $ per ogni milione di token in output.

- Il prezzo di GPT-4.1 mini è di $ 0,40 per l'input e di $ 1,60 per l'output.

- Il GPT-4.1 nano costa 0,10 $ in input e 0,40 $ in output.

L'utilizzo della memorizzazione nella cache dei prompt o dell'API Batch può ridurre ulteriormente questi costi, il che è ottimo per le applicazioni su larga scala. OpenAI si sta inoltre preparando a interrompere il supporto per GPT-4.5 Preview il 14 luglio 2025, citando le migliori prestazioni, la minore latenza e il costo inferiore di GPT-4.1.