La startup cinese di intelligenza artificiale DeepSeek ha appena rilasciato ufficialmente il suo ultimo modello linguistico di grandi dimensioni (LLM), DeepSeek-V3-0324. Con una capacità fino a 641 GB, questo modello è stato annunciato sulla piattaforma AI Hugging Face senza rivelare molte informazioni, in linea con lo stile di riservatezza sui nuovi prodotti che l'azienda ha sempre adottato finora.

La particolarità di questo modello è la licenza MIT, che ne consente il libero utilizzo per scopi commerciali. I primi risultati dei benchmark mostrano che DeepSeek-V3-0324 è in grado di funzionare su configurazioni hardware tradizionali, come Mac Studio di Apple con chip M3 Ultra. Lo scienziato dell'intelligenza artificiale Awni Hannun ha riferito che utilizzando questa configurazione è possibile raggiungere velocità di elaborazione superiori a 20 token al secondo. Questa capacità di eseguire un modello linguistico di grandi dimensioni su hardware di base in sede è in netto contrasto con l'approccio tradizionale che prevede l'utilizzo di enormi infrastrutture di data center per supportare modelli di intelligenza artificiale avanzati.

Secondo le informazioni fornite da DeepSeek, i test iniziali hanno evidenziato notevoli miglioramenti rispetto alle versioni precedenti. Questo modello è stato rigorosamente testato dagli stakeholder interni e ha dimostrato prestazioni eccellenti, superando persino tutti gli altri modelli concorrenti e superando Claude Sonnet 3.5 di Anthropic in attività che non richiedono una riflessione profonda. Tuttavia, a differenza dei modelli in stile Sonnet che richiedono un abbonamento a pagamento, DeepSeek-V3-0324 può essere scaricato e utilizzato in modo completamente gratuito.

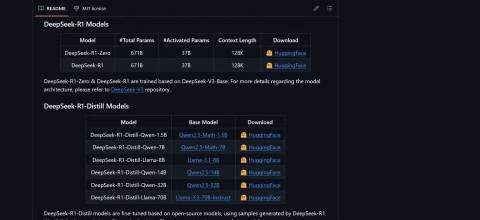

Tecnicamente, DeepSeek-V3-0324 utilizza un'architettura mista di esperti (MoE). Si distingue per la sua capacità di utilizzare selettivamente circa 37 miliardi dei 685 miliardi di parametri per attività, aumentando l'efficienza mediante la riduzione delle richieste di calcolo e mantenendo inalterate le prestazioni. Questo modello applica anche le tecnologie Multi-Head Latent Attention (MLA) e Multi-Token Prediction (MTP), che contribuiscono a migliorare la memoria del contesto e ad accelerare l'output.

Gli utenti possono accedere a DeepSeek-V3-0324 tramite Hugging Face, l'interfaccia di chat e l'API di OpenRouter e, se lo desiderano, la piattaforma di chat di DeepSeek. Anche il fornitore di servizi di inferenza Hyperbolic Labs fornisce l'accesso al modello.

Con il rilascio di DeepSeek-V3-0324, l'azienda continua ad affermare la propria posizione nella corsa allo sviluppo di modelli linguistici di grandi dimensioni, offrendo al contempo un'opzione potente e accessibile per la comunità di ricerca e sviluppo dell'intelligenza artificiale. La possibilità di funzionare su hardware di consumo, abbinata a una licenza gratuita, aprirà sicuramente numerose opportunità di applicazione pratica per questo modello nel prossimo futuro.