Meta lancia Llama 4: il LLM multimodale definitivo

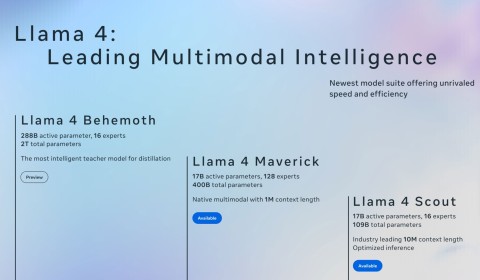

Questa serie include tre versioni: Llama 4 Scout, Llama 4 Maverick e Llama 4 Behemoth.

All'inizio di aprile 2025, Meta ha lanciato Llama 4 , l'ultima serie di modelli di intelligenza artificiale progettati per portare l'azienda a un livello superiore. Ogni nuovo modello Llama 4 presenta notevoli miglioramenti rispetto ai suoi predecessori: ecco le nuove caratteristiche più importanti da provare.

3. Architettura del mix di esperti (MoE)

Una delle caratteristiche più notevoli dei modelli Llama 4 è la nuova architettura MoE, una novità per la serie Llama, che utilizza un approccio diverso rispetto ai modelli precedenti. Nella nuova architettura, solo una piccola frazione dei parametri del modello viene attivata per ogni token, a differenza dei tradizionali modelli di trasformatori densi come Llama 3 e precedenti, in cui tutti i parametri vengono attivati per ogni attività.

Ad esempio, Llama 4 Maverick utilizza solo 17 miliardi di parametri attivi su 400 miliardi, con 128 esperti instradati e un esperto condiviso. Llama 4 Scout, il più piccolo della serie, ha un totale di 109 miliardi di parametri, attivandone solo 17 miliardi con 16 esperti.

La versione più grande del trio, Llama 4 Behemoth, utilizza 288 miliardi di parametri attivi (con 16 esperti) su un totale di quasi due trilioni di parametri. Grazie a questa nuova architettura, a ogni compito vengono assegnati solo due specialisti.

Grazie al cambiamento architettonico, i modelli della serie Llama 4 risultano più efficienti dal punto di vista computazionale durante l'addestramento e l'inferenza. Abilitando solo una piccola parte dei parametri si riducono i costi del servizio e la latenza. Grazie all'architettura MoE, Meta sostiene che Llama può essere eseguito su una singola GPU Nvidia H100, un'impresa impressionante considerando il numero di parametri. Sebbene non ci siano metriche specifiche, si ritiene che ogni query su ChatGPT utilizzi più GPU Nvidia, il che crea un overhead maggiore in quasi tutte le metriche misurabili.

2. Capacità di elaborazione multimodale nativa

Un altro importante aggiornamento dei modelli di intelligenza artificiale di Llama 4 è l'elaborazione multimodale nativa, che consente al trio di comprendere simultaneamente testo e immagini.

Ciò è possibile grazie alla combinazione effettuata nella fase di formazione iniziale, in cui i token testuali e visivi vengono integrati in un'architettura unificata. I modelli vengono addestrati utilizzando grandi quantità di dati di testo, immagini e video non etichettati.

Non c'è niente di meglio. Se ricordate, l'aggiornamento Llama 3.2 di Meta , rilasciato nel settembre 2024, ha introdotto una serie di nuovi modelli (10 in totale), tra cui 5 modelli di visione multimodale e 5 modelli di testo. Con questa generazione, l'azienda non ha bisogno di rilasciare modelli di testo e di visione separati, grazie alle capacità di elaborazione multimodale native.

Inoltre, Llama 4 utilizza un codificatore visivo migliorato, che consente ai modelli di gestire complesse attività di inferenza visiva e input multi-immagine, rendendoli in grado di gestire applicazioni che richiedono una comprensione avanzata di testo e immagini. L'elaborazione multimodale consente inoltre di utilizzare i modelli LLama 4 in una vasta gamma di applicazioni.

1. Finestra contestuale leader del settore

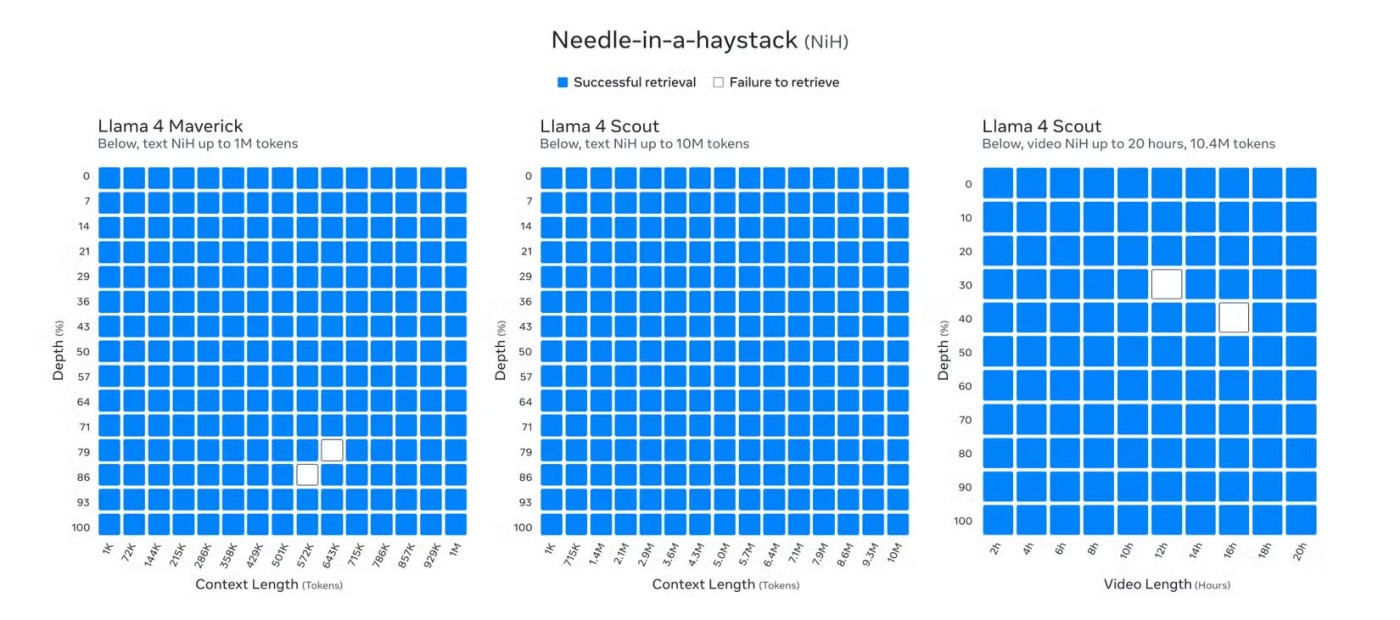

I modelli di intelligenza artificiale di Llama 4 vantano una finestra contestuale senza precedenti, pari a un massimo di 10 milioni di token. Sebbene Llama 4 Behemoth sia ancora in fase di sviluppo al momento della pubblicazione, Llama 4 Scout ha stabilito un nuovo punto di riferimento nel settore grazie alla sua capacità di supportare fino a 10 milioni di token di lunghezza del contesto, consentendo di immettere testo più lungo di 5 milioni di parole.

Questa lunghezza estesa del contesto rappresenta un incremento significativo rispetto agli 8k token di Llama 3 al momento del suo lancio e persino rispetto alla successiva espansione a 128k dopo l'aggiornamento a Llama 3.2. E non è solo la lunghezza del contesto di 10 milioni di Llama 4 Scout a essere interessante; Anche Llama 4 Maverick, con la sua lunghezza di un milione di contesti, è un'impresa impressionante.

Llama 3.2 è attualmente uno dei migliori chatbot AI per conversazioni prolungate. Tuttavia, la finestra di contesto ampliata di Llama 4 pone Llama in testa, superando la precedente finestra di contesto da 2 milioni di token di Gemini, i 200.000 di Claude 3.7 Sonnet e i 128.000 di GPT-4.5.

Grazie all'ampia finestra di contesto, la serie Llama 4 è in grado di gestire attività che richiedono l'inserimento di grandi quantità di informazioni. Questa ampia finestra è utile per attività quali l'analisi di documenti lunghi e multipli, l'analisi dettagliata di grandi basi di codice e il ragionamento su grandi set di dati.

Permette inoltre a Llama 4 di effettuare conversazioni prolungate, a differenza dei precedenti modelli di Llama e dei modelli di altre aziende di intelligenza artificiale. Se uno dei motivi per cui Gemini 2.5 Pro è il miglior modello di ragionamento è la sua ampia finestra di contesto, puoi immaginare quanto sia potente una finestra di contesto 5x o 10x.

I modelli Llama della serie 3 di Meta sono tra i migliori LLM sul mercato. Ma con il rilascio della serie Llama 4, Meta fa un ulteriore passo avanti non solo concentrandosi sul miglioramento delle prestazioni di inferenza (grazie alla nuova finestra di contesto leader del settore), ma anche garantendo i modelli più efficienti possibili utilizzando una nuova architettura MoE sia durante l'addestramento che durante l'inferenza.

Le capacità di elaborazione multimodale nativa di Llama 4, l'efficiente architettura MoE e l'ampia finestra di contesto lo posizionano come un modello di intelligenza artificiale aperto, ad alte prestazioni e flessibile, ponderato in grado di competere o superare i modelli leader per inferenza, codifica e molte altre attività.

Problemi con l'errore di chat di Microsoft Teams che non invia messaggi? Scopri le soluzioni dettagliate per gli ultimi problemi di Teams, dalla cancellazione della cache alle modifiche di rete. Torna a chattare senza problemi in pochi minuti!

Stanco di crash di Microsoft Teams con errori gravi? Ottieni la comprovata correzione del registro 2026 che risolve il problema in pochi minuti. Guida passo passo, screenshot e suggerimenti per una risoluzione definitiva. Funziona con le versioni più recenti!

Hai problemi con il portachiavi di errore di Microsoft Teams su Mac? Scopri soluzioni comprovate e dettagliate per macOS per tornare a collaborare senza problemi. Soluzioni rapide all'interno!

Hai problemi con il caricamento della scheda Wiki di Microsoft Teams? Scopri soluzioni passo passo comprovate per risolvere rapidamente il problema, ripristinare le schede Wiki e aumentare la produttività del team senza problemi.

Stanco di sentire l'audio ovattato o assente nel microfono di Microsoft Teams? Scopri come risolvere i problemi del microfono di Microsoft Teams con passaggi rapidi e comprovati. Un audio nitido ti aspetta!

Stanco degli errori di sincronizzazione di Gestione Attività di Microsoft Teams che interrompono il tuo flusso di lavoro? Segui le nostre soluzioni dettagliate e dettagliate per ripristinare la perfetta sincronizzazione delle attività tra Teams, Planner e To Do. Soluzioni rapide per un sollievo immediato!

Hai problemi con la lentezza di Microsoft Teams? Scopri come svuotare la cache di Microsoft Teams passo dopo passo per risolvere problemi di prestazioni, ritardi, arresti anomali e aumentare la velocità su Windows, Mac, web e dispositivi mobili. Soluzioni rapide e efficaci!

Problemi di rete di Microsoft Teams su una rete Wi-Fi pubblica? Ottieni soluzioni immediate come modifiche alla VPN, controlli delle porte e cancellazione della cache per ripristinare chiamate e riunioni senza problemi. Guida passo passo per un rapido sollievo.

Hai difficoltà a trovare il tuo ID Microsoft Teams o i dettagli del tuo account? Questa guida dettagliata mostra esattamente dove trovare il tuo ID Microsoft Teams e le informazioni del tuo account su desktop, web, dispositivi mobili e altro ancora, per una collaborazione senza interruzioni.

Stanco dell'errore 1200 di Microsoft Teams che blocca le tue chiamate al telefono? Scopri soluzioni rapide e dettagliate per iOS e Android per tornare a lavorare in team senza intoppi, senza bisogno di competenze tecniche!

Hai difficoltà a trovare la cartella di installazione di Microsoft Teams sul tuo PC? Questa guida dettagliata ti mostrerà i percorsi esatti per le installazioni di Teams, sia nuove che classiche, per utente e per computer. Risparmia tempo nella risoluzione dei problemi!

Scopri come creare e gestire un bot in Microsoft Teams (2026) con questa guida esperta. Dalla configurazione alla gestione avanzata, aumenta la produttività utilizzando gli ultimi strumenti di Bot Framework e Azure.

Frustrato perché la tua registrazione su Microsoft Teams non è riuscita? Scopri le cause più comuni, come problemi di autorizzazioni, limiti di spazio di archiviazione e problemi di rete, oltre a soluzioni dettagliate per prevenire futuri errori e registrare in modo impeccabile ogni volta.

Problemi di accesso a Microsoft Teams su Chromebook? Scopri le soluzioni dettagliate per risolvere rapidamente i problemi di accesso. Svuota la cache, aggiorna le app e altro ancora per un lavoro di squadra senza intoppi. Compatibile con l'ultima versione di Chrome OS!

Scopri come mantenere Microsoft Teams attivo e disponibile tutto il giorno. Suggerimenti, strumenti e impostazioni comprovati per evitare lo stato "Assente", aumentare la produttività e non perdere mai un colpo durante la tua giornata lavorativa.