OpenAI lancia GPT-4o, un ampio modello linguistico multimodale che supporta conversazioni in tempo reale, domande e risposte, generazione di testo e altro ancora.

OpenAI è uno dei fornitori che ha plasmato l' era dell'intelligenza artificiale generativa . Il successo e la popolarità di OpenAI si fondano sulla famiglia di modelli linguistici di grandi dimensioni (LLM) GPT dell'azienda , tra cui GPT-3 e GPT-4, insieme al servizio di intelligenza artificiale conversazionale ChatGPT .

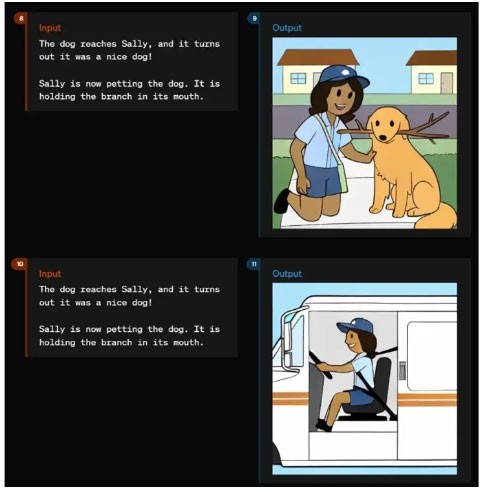

Il 13 maggio 2024, durante l'evento Spring Updates dell'azienda, OpenAI ha annunciato GPT-4 Omni (GPT-4o) come nuovo modello linguistico multimodale di punta dell'azienda. Nell'ambito dell'evento, OpenAI ha pubblicato diversi video che dimostrano le capacità intuitive di feedback vocale e di output del modello.

Nel luglio 2024, OpenAI ha rilasciato una versione più piccola di GPT-4o: GPT-4o mini . Si tratta del modello di piccole dimensioni più avanzato dell'azienda.

Che cosa è GPT-4o?

GPT-4o è il modello di punta del portafoglio tecnologico LLM di OpenAI. O sta per Omni e non è solo una forma di campagna pubblicitaria, ma si riferisce piuttosto alle molteplici modalità del modello per testo, immagini e audio.

Il modello GPT-4o segna una nuova evoluzione del GPT-4 LLM, rilasciato per la prima volta da OpenAI a marzo 2023. Questo non è il primo aggiornamento di GPT-4, poiché il modello è stato lanciato per la prima volta a novembre 2023, con il rilascio di GPT-4 Turbo. L'acronimo GPT sta per Generative Pre-Trained Transformer. Il modello del trasformatore è un elemento fondamentale dell'intelligenza artificiale generativa, in quanto fornisce un'architettura di rete neurale in grado di comprendere e generare nuovi output.

GPT-4o supera di gran lunga quanto offerto da GPT-4 Turbo in termini di capacità e prestazioni. Come il suo predecessore GPT-4, GPT-4o può essere utilizzato nei casi in cui è necessaria la generazione di testo, ad esempio riassunti, domande e risposte basate sulla conoscenza. Questo modello è anche in grado di ragionare, risolvere problemi complessi e programmare.

Il modello GPT-4o introduce una nuova risposta rapida all'input audio che, secondo OpenAI, è simile a quella umana, con un tempo di risposta medio di 320 millisecondi. Il modello può anche rispondere con una voce generata dall'intelligenza artificiale che sembra umana.

Invece di avere modelli separati che comprendono audio, immagini (che OpenAI chiama visione) e testo, GPT-4o combina queste modalità in un unico modello. Pertanto, GPT-4o è in grado di comprendere qualsiasi combinazione di input di testo, immagine e audio e di rispondere con un output in uno qualsiasi di questi formati.

La promessa di GPT-4o e delle sue capacità di feedback multimodale audio ad alta velocità è di consentire al modello di interagire in modo più naturale e intuitivo con gli utenti.

GPT-4o mini è il modello più veloce di OpenAI e consente applicazioni a costi inferiori. GPT-4o mini è più intelligente di GPT-3.5 Turbo e più economico del 60%. I dati di formazione sono validi fino a ottobre 2023. GPT-4o mini è disponibile nei modelli di testo e visione per gli sviluppatori tramite l'API degli assistenti, l'API dei completamenti chat e l'API Batch. La versione Mini è disponibile anche su ChatGPT, Free, Plus e Team per gli utenti.

Cosa può fare GPT-4o?

Al momento del suo rilascio, GPT-4o era il più potente tra tutti i modelli OpenAI in termini di funzionalità e prestazioni.

Tra le numerose cose che GPT-4o può fare ci sono:

- Interazione in tempo reale . Il modello GPT-4o è in grado di svolgere conversazioni verbali in tempo reale senza ritardi evidenti.

- Domande e risposte basate sulla conoscenza . Come tutti i precedenti modelli GPT-4, GPT-4o è stato addestrato utilizzando una knowledge base ed è in grado di rispondere alle domande.

- Riassumere e generare testo . Come tutti i precedenti modelli GPT-4, GPT-4o può eseguire comuni attività LLM di testo, tra cui la sintesi e la generazione di testo.

- Ragionamento e generazione multimodale . GPT-4o integra testo, parlato e immagini in un unico modello, consentendo l'elaborazione e la risposta combinate di tipi di dati. Il modello è in grado di comprendere audio, immagini e testo alla stessa velocità. Può anche generare feedback tramite audio, immagini e testo.

- Elaborazione del linguaggio e dell'audio . GPT-4o ha capacità avanzate per gestire oltre 50 lingue diverse.

- Analisi del sentimento . Il modello comprende il sentimento dell'utente attraverso diverse modalità di testo, audio e video.

- Tono della voce . GPT-4o può generare voci con sfumature emotive. Ciò lo rende efficace per le applicazioni che richiedono una comunicazione delicata e sfumata.

- Analisi del contenuto audio . Il modello è in grado di generare e comprendere il linguaggio parlato, il che può essere applicato ai sistemi ad attivazione vocale, all'analisi dei contenuti audio e alla narrazione interattiva.

- Traduzione in tempo reale. Le capacità multimodali di GPT-4o possono supportare la traduzione in tempo reale da una lingua all'altra.

- Comprendere immagini e video. Il modello è in grado di analizzare immagini e video, consentendo agli utenti di caricare contenuti visivi che GPT-4o può comprendere, interpretare e analizzare.

- Analisi dei dati . Le capacità di ragionamento e di visione consentono agli utenti di analizzare i dati contenuti nei grafici. GPT-4o può anche generare grafici di dati basati su analisi o prompt.

- Carica file. Oltre alle soglie di conoscenza, GPT-4o supporta il caricamento di file, consentendo agli utenti di fornire dati specifici per l'analisi.

- Consapevolezza contestuale e memoria. GPT-4o può ricordare le interazioni precedenti e mantenere il contesto nelle conversazioni lunghe

- Ampia finestra di contesto . Grazie a una finestra di contesto che supporta fino a 128.000 token, GPT-4o riesce a mantenere la coerenza anche in conversazioni o documenti lunghi, il che lo rende adatto per analisi dettagliate.

- Riduce le allucinazioni e migliora la sicurezza . Il modello è progettato per ridurre al minimo la creazione di informazioni inaccurate o fuorvianti. GPT-4o include protocolli di sicurezza avanzati per garantire agli utenti un output coerente e sicuro.

Come utilizzare GPT-4o

Esistono diversi modi in cui utenti e organizzazioni possono utilizzare GPT-4o.

- ChatGPT è gratuito. Il modello GPT-4o sarà reso disponibile gratuitamente agli utenti del chatbot ChatGPT di OpenAI. Quando disponibile, GPT-4o sostituirà l'impostazione predefinita attuale per gli utenti di ChatGPT Free. Gli utenti di ChatGPT Free avranno un accesso limitato ai messaggi e non potranno accedere ad alcune funzionalità avanzate, tra cui il caricamento di file e l'analisi dei dati.

- ChatGPT Plus . Gli utenti del servizio a pagamento di OpenAI per ChatGPT avranno accesso completo a GPT-4o, senza le limitazioni di funzionalità disponibili per gli utenti gratuiti.

- Accesso API . Gli sviluppatori possono accedere a GPT-4o tramite l'API di OpenAI. Ciò consente l'integrazione nelle applicazioni per sfruttare appieno le capacità di GPT-4o per le attività.

- Applicazione desktop. OpenAI ha integrato GPT-4o nelle applicazioni desktop, tra cui una nuova app per macOS di Apple, rilasciata anch'essa il 13 maggio.

- GPT personalizzato. Le organizzazioni possono creare versioni GPT personalizzate di GPT-4o per soddisfare specifiche esigenze aziendali o dipartimentali. È probabile che i modelli personalizzati vengano resi disponibili agli utenti tramite il GPT Store di OpenAI.

- Servizi Microsoft OpenAI. Gli utenti possono esplorare le funzionalità di GPT-4o in modalità anteprima in Microsoft Azure OpenAI Studio, specificamente progettato per gestire input multimodali tra cui testo e visione. Questa versione iniziale consente ai clienti di Azure OpenAI Service di sperimentare le funzionalità di GPT-4o in un ambiente controllato, con l'intenzione di espanderne le funzionalità in futuro.

Inoltre, i lettori possono fare riferimento a: Differenze tra GPT-4, GPT-4 Turbo e GPT-4o .